Grafikkarten haben eine faszinierende Reise hinter sich. Sie sind das Herzstück moderner Computertechnologie, wenn es darum geht, atemberaubende visuelle Erlebnisse zu schaffen – sei es in Videospielen, Filmen oder anspruchsvollen wissenschaftlichen Simulationen. Doch der Weg zu den beeindruckenden Grafiken, die wir heute kennen, war lang und voller technischer Meilensteine.

Von den bescheidenen Anfängen, in denen einfache Pixel auf den Bildschirm gezaubert wurden, bis hin zu fotorealistischem Raytracing in Echtzeit, hat die Entwicklung der Grafikkarten die Art und Weise, wie wir digitale Medien erleben, revolutioniert.

In diesem Artikel werfen wir einen Blick auf die Evolution dieser Technologie, erkunden die wichtigsten Schritte und Innovationen und erklären, wie aus einfachen Pixeln die realistischen Welten entstanden sind, die wir heute genießen.

Die frühen Anfänge: 2D-Grafik und einfache Pixel

In den frühen Tagen der Computergrafik war die Welt der Bilder auf dem Bildschirm eine simple und begrenzte Angelegenheit. Die ersten Grafikkarten waren einfache Schaltkreise, die kaum mehr leisten konnten, als eine Handvoll Farben und grobe Pixel darzustellen. Diese sogenannten 2D-Grafikkarten waren für einfache Aufgaben wie die Anzeige von Texten und statischen Bildern ausgelegt. Spiele und grafische Anwendungen, wie wir sie heute kennen, waren damals noch Science-Fiction.

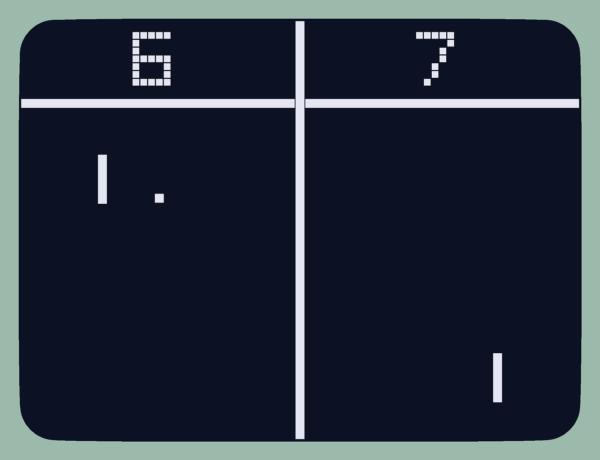

Ein herausragendes Beispiel aus dieser Ära ist das Spiel Pong, das 1972 erschien und als eines der ersten Videospiele gilt. Die Grafik bestand aus wenigen weißen Pixeln auf einem schwarzen Hintergrund – schlicht, aber dennoch revolutionär für die damalige Zeit. Die ersten Grafikkarten ermöglichten solche Anwendungen, indem sie Pixel rasterweise auf den Bildschirm brachten und dabei einfache geometrische Formen und Farben erzeugten.

Eine der ersten kommerziellen Grafikkarten, die IBM Monochrome Display Adapter (MDA), erschien 1981. Sie bot eine Auflösung von 720×350 Pixeln, jedoch nur in Schwarz-Weiß. Der erste Schritt hin zu mehr Farbvielfalt kam kurz darauf mit dem Color Graphics Adapter (CGA), der eine Palette von 16 Farben unterstützen konnte – ein riesiger Sprung für die damalige Technologie.

Trotz dieser Fortschritte waren die Möglichkeiten von 2D-Grafikkarten begrenzt. Die meisten Computerspiele und Anwendungen waren grafisch rudimentär, und die Vorstellung von realistischen Darstellungen war noch in weiter Ferne. Doch diese frühen Entwicklungen legten den Grundstein für die technologischen Sprünge, die in den folgenden Jahrzehnten stattfinden sollten.

Der Übergang zur 3D-Grafik

Der Sprung von 2D- zu 3D-Grafik markierte einen bedeutenden Wendepunkt in der Geschichte der Computergrafik. Mit dem Aufkommen der ersten 3D-Grafikkarten begann eine neue Ära, die nicht nur die Art und Weise veränderte, wie Spiele entwickelt und erlebt wurden, sondern auch die gesamte Technologiebranche revolutionierte.

In den frühen 1990er Jahren machte die Technologie einen gewaltigen Sprung nach vorne, als 3D-Beschleunigung in Grafikkarten integriert wurde. Diese neuen Karten waren in der Lage, dreidimensionale Objekte in Echtzeit zu rendern, was eine völlig neue Welt der Möglichkeiten eröffnete. Anstatt flacher, zweidimensionaler Bilder konnten nun komplexe 3D-Modelle mit Perspektive, Tiefe und realistischen Bewegungen dargestellt werden.

Ein Schlüsselmoment in dieser Entwicklung war die Einführung der 3Dfx Voodoo-Grafikkarte im Jahr 1996. Die Voodoo war eine der ersten Grafikkarten, die speziell für die 3D-Beschleunigung konzipiert war. Mit ihrer Fähigkeit, Texturen auf 3D-Modelle zu legen und realistische Licht- und Schatteneffekte zu erzeugen, setzte sie neue Maßstäbe. Spiele wie Quake und Tomb Raider zeigten eindrucksvoll, was mit dieser neuen Technologie möglich war. Diese Titel boten ein immersives Spielerlebnis, das vorher undenkbar gewesen wäre.

Mit der Einführung von 3D-Grafik wurden auch die Anforderungen an die Hardware deutlich komplexer. Grafikkarten mussten nun eine Vielzahl von Aufgaben bewältigen, darunter die Berechnung von Geometrie, das Mapping von Texturen und die Simulation von Beleuchtung. Diese Entwicklung führte zu einer rasanten Verbesserung der Leistung und Funktionalität von Grafikkarten, da Hersteller wie NVIDIA und ATI (heute AMD) ständig neue und leistungsfähigere Modelle auf den Markt brachten.

Die Einführung der 3D-Grafik beschleunigte auch den Wettbewerb in der Spieleindustrie. Entwickler begannen, die neuen Möglichkeiten auszureizen und erstellten immer komplexere und realistischere Spielewelten. Dieser Wettlauf um die beste Grafik führte schließlich zu dem, was wir heute als „Grafik-Revolution“ bezeichnen.

Die Ära der programmierbaren Shader

Mit dem Durchbruch der 3D-Grafik war das Fundament gelegt, aber die Entwicklung hörte hier keineswegs auf. In den frühen 2000er Jahren stand die nächste Revolution vor der Tür: die Einführung programmierbarer Shader. Diese Technologie veränderte die Grafikwelt erneut und brachte uns einen großen Schritt näher an das, was wir heute als Photorealismus bezeichnen.

Was sind Shader?

Shader sind spezielle Programme, die auf der Grafikkarte ausgeführt werden und dazu dienen, das Aussehen von Oberflächen und Effekten in einem 3D-Raum zu bestimmen. Früher wurden diese Aufgaben von der Grafikhardware fest vorgegeben, was die Möglichkeiten stark einschränkte. Mit der Einführung programmierbarer Shader konnten Entwickler jedoch erstmals individuell festlegen, wie Licht, Schatten, Farben und Texturen auf Objekte angewendet werden.

Mit dieser neuen Flexibilität war es möglich, realistischere Materialien zu erzeugen, komplexe Lichteffekte wie Spiegelungen oder Transparenzen darzustellen und sogar Effekte wie Feuer, Wasser oder Rauch realistisch nachzubilden. Die Grafikkarten dieser Ära, wie die NVIDIA GeForce 3 (2001) und die ATI Radeon 9700 (2002), boten Unterstützung für sogenannte „Vertex“- und „Pixelshader“, die eine präzise Kontrolle über jeden einzelnen Pixel und Vertex in einer Szene ermöglichten.

Revolutionäre Spiele und Anwendungen

Spiele wie Far Cry (2004) und Half-Life 2 (2004) waren Paradebeispiele für die beeindruckenden Möglichkeiten programmierbarer Shader. Die realistische Darstellung von Wasserflächen, das Spiel von Licht und Schatten sowie die detaillierten Texturen ließen die Spielwelten lebendiger und glaubwürdiger erscheinen als je zuvor. Diese Titel setzten neue Maßstäbe und zeigten eindrucksvoll, wie weit sich die Grafiktechnologie entwickelt hatte.

Auch in anderen Bereichen, wie der Filmproduktion und der wissenschaftlichen Visualisierung, fanden programmierbare Shader schnell Anwendung. Sie ermöglichten die Erstellung atemberaubender Spezialeffekte und realistischer Animationen, die zuvor nur mit enormem Aufwand und spezialisierter Hardware möglich gewesen wären.

Der Weg zur fotorealistischen Grafik

Die Ära der programmierbaren Shader war ein entscheidender Schritt auf dem Weg zum Photorealismus in der Computergrafik. Sie gab Entwicklern die Werkzeuge an die Hand, um Grafiken nicht nur optisch ansprechender, sondern auch technisch präziser und realitätsnäher zu gestalten. Dieser Fortschritt bereitete den Boden für die nächste große Innovation: Raytracing.

Raytracing und der Weg zum Photorealismus

Nachdem programmierbare Shader die Tür zur realistischen Grafik weit aufgestoßen hatten, stand eine Technologie bereit, die die Branche ein weiteres Mal revolutionieren sollte: Raytracing. Diese Technik, die bis vor wenigen Jahren hauptsächlich in der Filmindustrie eingesetzt wurde, brachte die Grafikqualität auf ein völlig neues Level und ermöglichte einen Grad an Realismus, der zuvor unerreichbar war.

Was ist Raytracing?

Raytracing ist eine Methode zur Berechnung von Lichtstrahlen und deren Interaktionen mit Oberflächen in einer 3D-Szene. Dabei wird jeder Lichtstrahl simuliert, um festzustellen, wie er reflektiert, gebrochen oder absorbiert wird, bevor er auf das Auge (oder die Kamera) trifft. Diese Technik ermöglicht es, extrem realistische Licht- und Schatteneffekte zu erzeugen, einschließlich Reflexionen, Brechungen und weichen Schatten.

Im Gegensatz zu den herkömmlichen Rasterisierungsmethoden, die Licht und Schatten nur näherungsweise darstellen, ermöglicht Raytracing eine physikalisch korrekte Simulation von Licht. Dies führt zu Bildern, die nicht nur realistisch aussehen, sondern sich auch so „anfühlen“, als ob sie aus der echten Welt stammen.

Raytracing in Echtzeit: Eine technische Meisterleistung

Historisch gesehen war Raytracing extrem rechenintensiv und daher nur für vorgerenderte Filme oder Bilder geeignet. Die Idee, diese Technologie in Echtzeit in Spielen einzusetzen, schien lange Zeit unmöglich. Doch mit der Einführung der NVIDIA RTX-Serie im Jahr 2018 wurde genau das Realität.

Die RTX-Grafikkarten kombinierten traditionelle Rasterisierung mit Raytracing-Techniken und ermöglichten so eine bisher unerreichte Grafikqualität in Echtzeit. Spiele wie Battlefield V und Cyberpunk 2077 waren unter den ersten Titeln, die von dieser Technologie profitierten. Sie boten atemberaubende visuelle Effekte, wie realistische Reflexionen auf nassen Oberflächen, detaillierte Schattenwürfe und lebensechte Beleuchtung, die den Unterschied zwischen digitaler und realer Welt fast verschwimmen lassen.

Und Grafikkarten die das leisten können, sind heute auch ohne weiteres bezahlbar. Die KFA² GeForce RTX 4070 kostet z.B. je nach Ausstattung und Variante zwischen 540 und 620 Euro.

Die Auswirkungen auf die Branche

Raytracing hat nicht nur die Spielgrafik revolutioniert, sondern auch andere Bereiche beeinflusst. In der Architekturvisualisierung, im Produktdesign und in der Filmproduktion wird Raytracing genutzt, um fotorealistische Renderings zu erstellen, die den Betrachter täuschend echt in andere Welten versetzen können.

Die Einführung von Raytracing hat auch die Anforderungen an die Hardware dramatisch erhöht. Um diese Technik in vollem Umfang nutzen zu können, sind leistungsstarke Grafikkarten notwendig, die über spezialisierte Recheneinheiten, sogenannte „RT Cores“, verfügen. Dies hat den Markt für High-End-Grafikkarten angeheizt und die Entwicklung von immer leistungsfähigeren Modellen vorangetrieben.

Raytracing ist heute auf dem besten Weg, zum Standard in der Computergrafik zu werden, und markiert einen entscheidenden Schritt in der Evolution der Grafikkarten.

Grafikkarten heute: KI und Beyond

Während Raytracing die Grafikqualität auf ein neues Level hob, zeichnet sich ein weiterer bedeutender Trend in der Welt der Grafikkarten ab: der Einsatz von Künstlicher Intelligenz (KI). Diese Technologie verändert nicht nur die Art und Weise, wie Grafiken gerendert werden, sondern erweitert auch die Möglichkeiten, die Grafikkarten bieten können, weit über die reine Grafik hinaus.

KI in Grafikkarten: Ein Überblick

Die Integration von KI in moderne Grafikkarten begann mit der Einführung von Technologien wie NVIDIA’s Deep Learning Super Sampling (DLSS). DLSS nutzt neuronale Netzwerke, um niedrig aufgelöste Bilder in Echtzeit hochzuskalieren, wodurch eine nahezu native Auflösung erreicht wird – und das bei deutlich geringerer Rechenlast. Diese Technik ermöglicht es, Spiele in hoher Qualität und bei hohen Bildraten zu genießen, ohne dass die Hardware bis an ihre Grenzen belastet wird.

Ein weiteres Beispiel für den Einsatz von KI ist die Optimierung von Raytracing-Effekten. Durch KI können bestimmte Aspekte des Raytracing-Prozesses, wie die Berechnung von Lichtstrahlen, beschleunigt werden, was zu einer effizienteren Nutzung der Ressourcen führt. Dies trägt dazu bei, die Leistung zu verbessern und gleichzeitig die visuelle Qualität aufrechtzuerhalten.

Beyond Graphics: KI-Anwendungen auf der Grafikkarte

Moderne Grafikkarten werden nicht mehr nur für die Grafikverarbeitung eingesetzt. Dank ihrer enormen Rechenleistung und der Fähigkeit, parallele Berechnungen durchzuführen, spielen sie eine immer wichtigere Rolle in anderen Bereichen, wie der KI-Forschung, der Datenanalyse und der wissenschaftlichen Simulation.

In der Praxis bedeutet dies, dass Grafikkarten heute in Bereichen wie dem maschinellen Lernen, der medizinischen Bildverarbeitung und sogar in autonomen Fahrsystemen eingesetzt werden. GPUs (Graphics Processing Units) sind aufgrund ihrer Architektur besonders gut geeignet, komplexe mathematische Operationen durchzuführen, die für das Training von KI-Modellen notwendig sind. Dies hat dazu geführt, dass Grafikkarten zu einem unverzichtbaren Werkzeug in der modernen Forschung und Entwicklung geworden sind.

Zukunftsausblick: Was erwartet uns als Nächstes?

Die Weiterentwicklung der Grafikkarten ist eng mit der kontinuierlichen Verbesserung der KI-Technologie verbunden. Es ist absehbar, dass zukünftige Grafikkarten noch leistungsfähigere KI-Algorithmen integrieren werden, die nicht nur die Grafik, sondern auch die Rechenleistung in anderen Bereichen weiter optimieren.

Ein weiterer spannender Trend ist die Verschmelzung von virtuellen und realen Welten durch Augmented Reality (AR) und Virtual Reality (VR). Diese Technologien werden stark von den Fortschritten in der Grafik- und KI-Technologie profitieren. In der Zukunft könnten Grafikkarten in der Lage sein, komplette virtuelle Welten in Echtzeit zu simulieren, die von den physischen nicht mehr zu unterscheiden sind.

Grafikkarten im Wandel: Ein unaufhaltsamer Fortschritt

Die Entwicklung der Grafikkarten zeigt, dass wir uns in einem ständigen Wandel befinden, angetrieben von Innovationen, die sowohl die Leistung als auch die Anwendungsbereiche stetig erweitern. Vom Rendern einfacher Pixel bis hin zu KI-gesteuerten Photorealismus hat die Reise der Grafikkarten die Art und Weise, wie wir die digitale Welt erleben, radikal verändert.

Fazit

Die Evolution der Grafikkarten ist eine Geschichte des ständigen Fortschritts und der Innovation. Was einst als einfache Hardware begann, die lediglich in der Lage war, rudimentäre 2D-Grafiken darzustellen, hat sich über die Jahrzehnte zu einer hochkomplexen Technologie entwickelt, die heute photorealistische Bilder in Echtzeit erzeugen kann.

Jede Phase dieser Entwicklung – von den ersten Pixelgrafiken über den Durchbruch der 3D-Darstellung, die Einführung programmierbarer Shader bis hin zur modernen Raytracing-Technologie – hat die Möglichkeiten dessen, was auf einem Bildschirm dargestellt werden kann, revolutioniert.

Besonders in den letzten Jahren haben Grafikkarten durch den Einsatz von Künstlicher Intelligenz eine neue Dimension erreicht. Diese Technologie ermöglicht nicht nur beeindruckende Grafikdarstellungen, sondern erweitert die Einsatzmöglichkeiten von Grafikkarten weit über den Bereich der Unterhaltung hinaus. In Forschung, Medizin und Industrie spielen GPUs heute eine Schlüsselrolle und treiben Innovationen in vielfältigen Bereichen voran.

Die Zukunft der Grafikkarten sieht ebenso vielversprechend aus. Mit der fortschreitenden Entwicklung von KI und der zunehmenden Verschmelzung von virtuellen und realen Welten durch AR und VR stehen wir möglicherweise am Beginn einer neuen Ära, in der die Grenzen zwischen digitaler und physischer Realität immer weiter verschwimmen.

Was auch immer die nächsten Jahre bringen mögen, eines ist sicher: Die Evolution der Grafikkarten wird uns weiterhin faszinieren und die Art und Weise, wie wir digitale Inhalte erleben, nachhaltig beeinflussen.

In einer Welt, in der Technologie eine immer zentralere Rolle spielt, sind Grafikkarten ein perfektes Beispiel dafür, wie technischer Fortschritt unsere Vorstellungen von Realität und Fiktion ständig neu definiert. Und so bleibt es spannend, welchen Weg diese Reise als Nächstes einschlagen wird.